神经网络中的知识蒸馏-CSDN博客

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

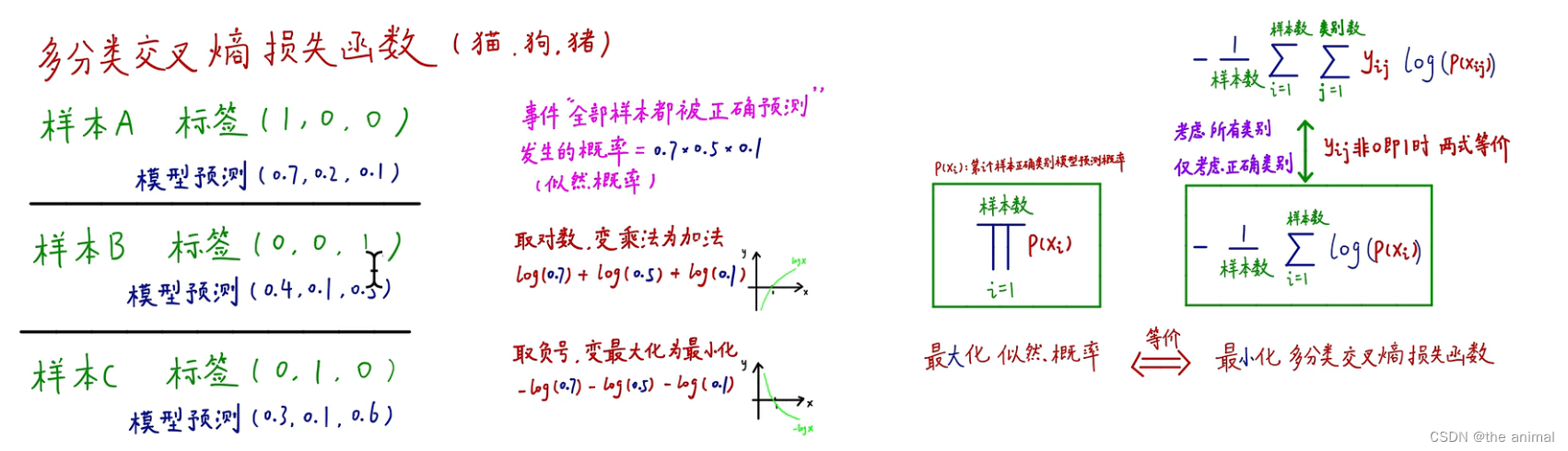

多分类交叉熵损失函数每个样本的标签已经给出模型给出在三种动物上的预测概率。将全部样本都被正确预测的概率求得为0.70.50.1也称为似然概率。优化的目标就是希望似然概率最大化。如果样本很多概率不断连乘就会造成概率越来越小。对其取对数使其最大化。在实际运用中损失函数都是求最小化所以取负号将最大化变为最小化。

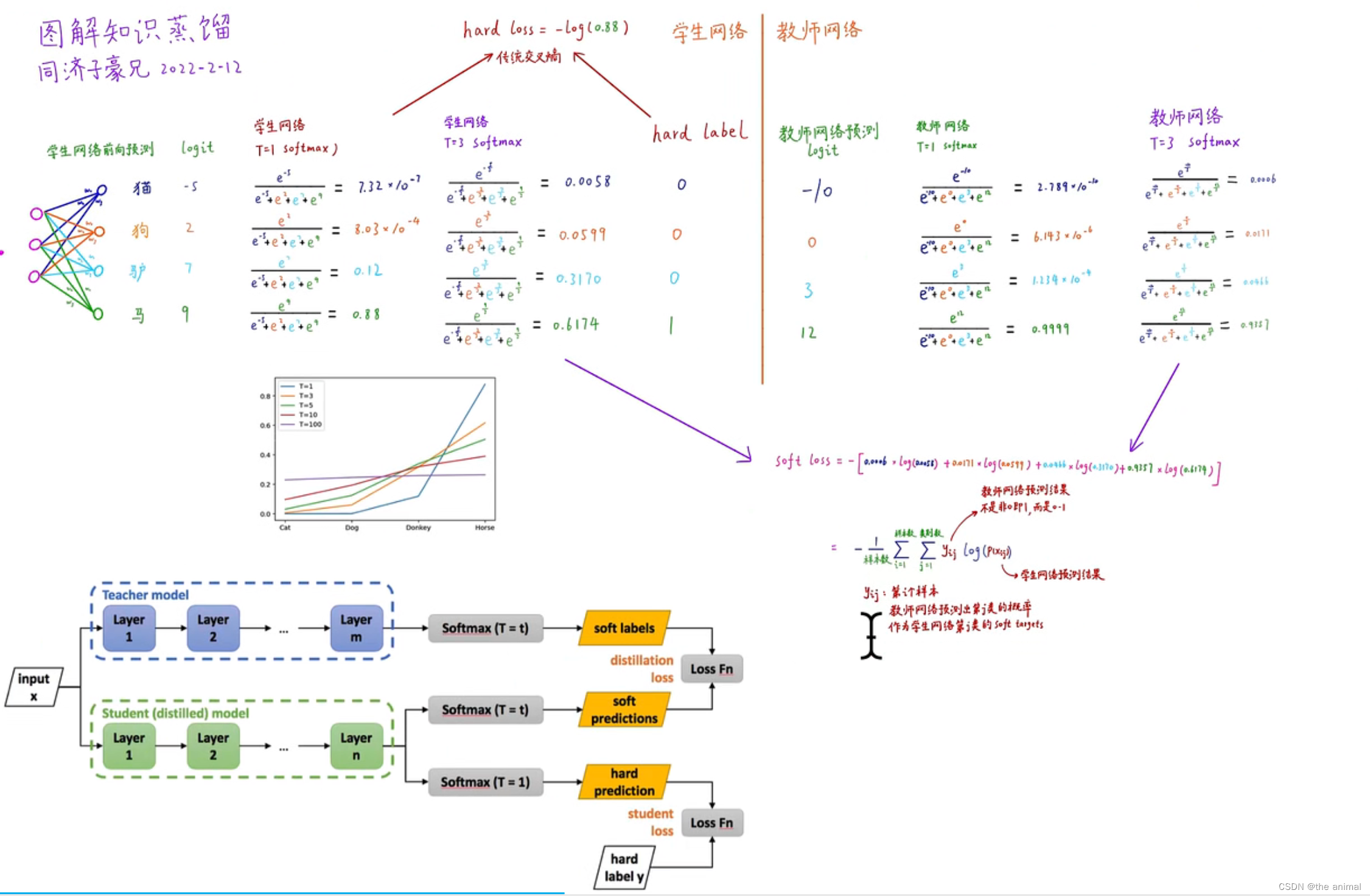

教师–学生网络的方法属于迁移学习的一种。迁移学习也就是将一个模型的性能迁移到另一个模型上而对于教师–学生网络教师网络往往是一个更加复杂的网络具有非常好的性能和泛化能力可以用这个网络来作为一个soft target来指导另外一个更加简单的学生网络来学习使得更加简单、参数运算量更少的学生模型也能够具有和教师网络相近的性能也算是一种模型压缩的方式。将教师网络的知识迁移到学生网络就是知识蒸馏。

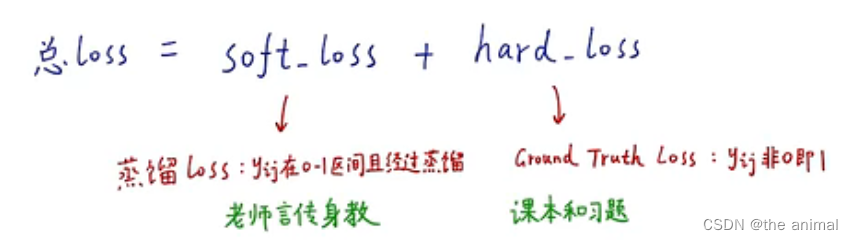

知识蒸馏用教师网络的“soft target”作为学生网络的label。使用一个额外的数据集将数据集先送入教师网络中获得soft target。 将数据集和label送入学生网络。如果 soft target的熵很高也就是不同类别的概率差异非常小那么这就提供了非常多的信息。假如使用hard target作为训练label比如猫的label为100那么网络只能学习到猫的梯度而在soft target可以得出猫和狗更像和汽车不像。

流程

T越大输入的结果越soft包含的知识也就越多。在训练的时候教师网络和学生网络的T相同在预测的时候T为1。

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |