【文本分类】基于预训练语言模型的BERT-CNN多层级专利分类研究

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

·阅读摘要:

本文利用BERT的预训练数据,结合CNN,应用于专利分类。由于专利的特性,本文还提出使用多层级方法来增强模型。(文章发表在《中文信息学报》,核心期刊)

·参考文献:

[1]陆晓蕾,倪斌.基于预训练语言模型的BERT-CNN多层级专利分类研究[J].中文信息学报,2021,35(11):70-79.

[0] 引言

提出工业界和学术界产生了大量专利申请,现行《国际专利分类法》包含 “部—类—亚 类—组”四个层级,其中“组”级共含有7万多种类别,人工太难分辨,所以提出用神经网络来分类。

【思考一】:专利分类作为文本分类中的一个垂直领域,标签有多层级、多标签的特点,不像做新闻分类、情感分类很多时候标签单一、且简单、都是自定义的。所以专利分类写论文更有“点”可写。

[1] 相关研究

此小节论述了文本分类的综述,从机器学习到神经网络到词向量、Elmo、GPT、Transformer、BERT。

最后提出BERT也是有缺点的。“虽然BERT提供了下游任务的简单接口,可以直接进行文本分类。然而,BERT作为预训练语言模型,关于其作为文档向量的研究和应用

尚不多见。”

然后说fastText可以做文档向量,效果也不错,但是它使用的是word embedding,不能解决语义(多义词)问题。

最后的idea就是把BERT与fastText结合。

[2] 研究方法

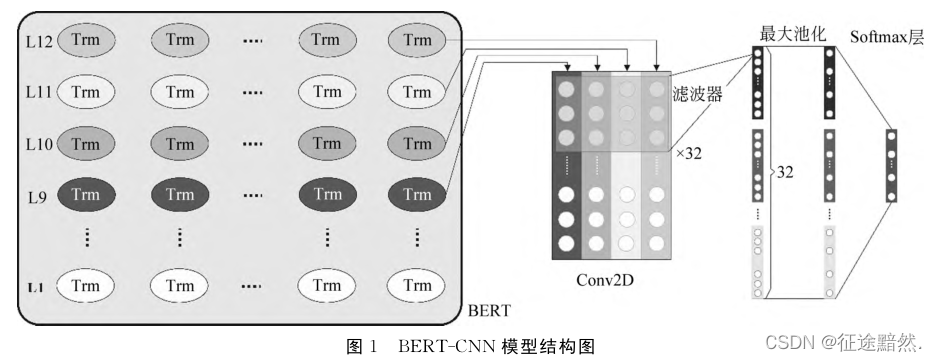

[2.1] BERT-CNN模型结构

上图一目了然。作者使用BERT的后4层,作为卷积的输入,之后经过池化、softmax来分类。

【思考二】:其实拿BERT的最后一层接fc就能直接做文本分类。

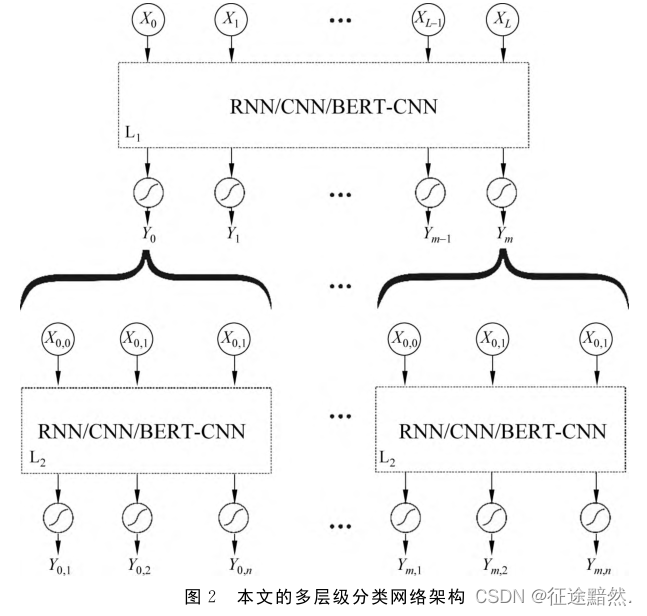

[2.2] 多层文本分类架构

作者提供了一种处理标签有层级关系的文本分类办法。

首先对所有数据、一级标签进行分类;之后依次对所有归类为一级标签A的数据、一级标签A的子标签进行分类,对所有归类为一级标签B的数据、一级标签B的子标签进行分类,对所有归类为一级标签…的数据、一级标签…的子标签进行分类。

【思考三】:文章没有解决多标签问题。

[3] 实验与结果

[3.1] 数据集

数据集采用国家信息中心提供的全国专利申请数据 。数据总量达到277万条记录。时间跨度为2017年全年(按照专利申请时间统计),地域覆盖全国。

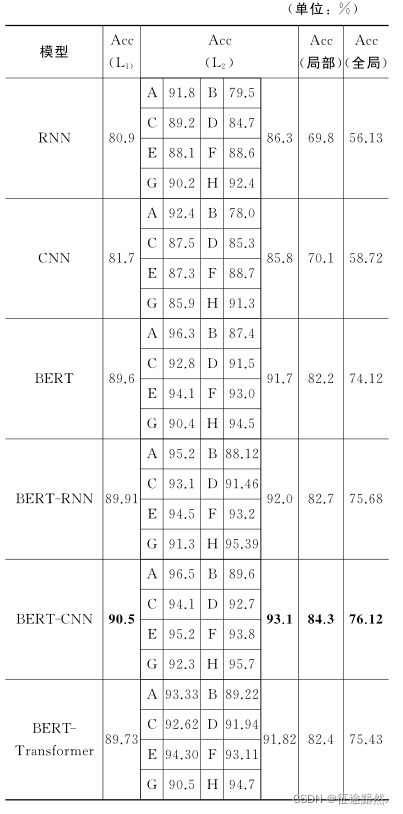

[3.3] 实验结果

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |