【Ubuntu-大数据】spark安装配置

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

这里写目录

参考的 文章 http://dblab.xmu.edu.cn/blog/931-2/

一、实现需要先安装好Hadoop3

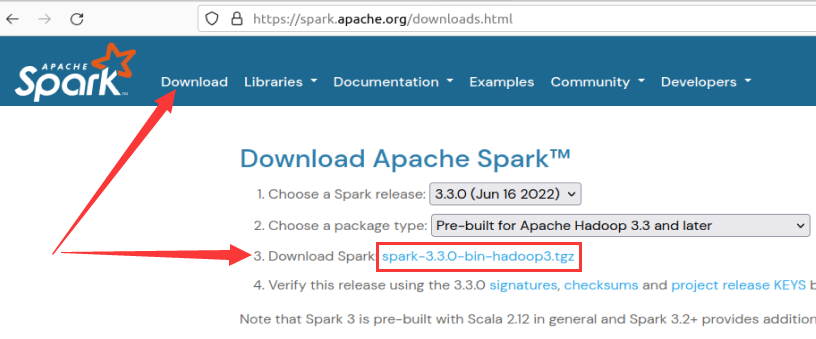

1、官网下载3版本

2、单机模式 安装配置

Spark部署模式主要有四种

- Local模式单机模式

- Standalone模式使用Spark自带的简单集群管理器、

- YARN模式使用YARN作为集群管理器

- Mesos模式使用Mesos作为集群管理器。

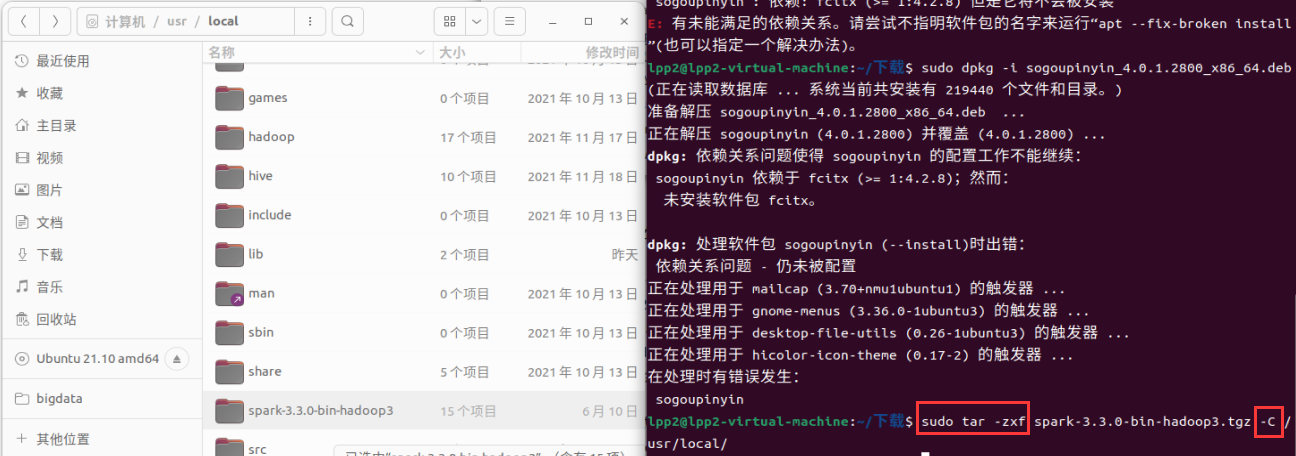

1解压压缩包到之前Hadoop安装的目录本地计算机-usr-local

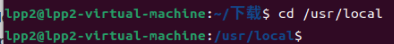

2cd进入该目录

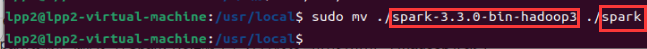

3解压的压缩包名称太长了我们改成spark

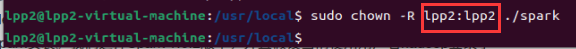

4赋予该文件相关权限lpp2是你的hadoop名字可以在设置的【用户】中查看

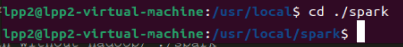

5进入spark文件目录

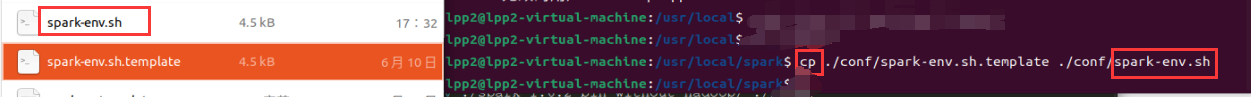

6使用cp复制其中的配置文件命名为

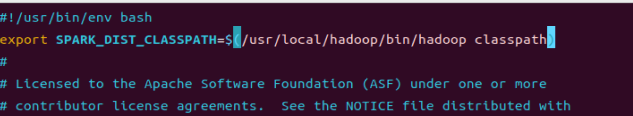

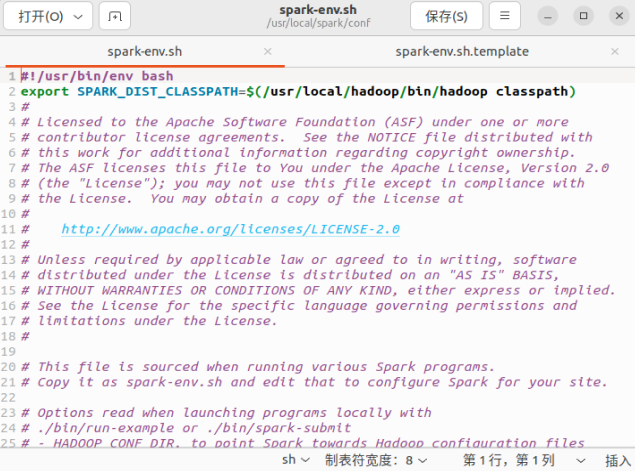

7编辑spark-env.sh文件(vim ./conf/spark-env.sh)在第一行添加以下配置信息:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

按i进入插入模式插入完成

然后按下退出键ESC然后是shift+冒号健输入一个英文冒号他就会在最下面生成一个冒号。

这时候我们输入wq然会回车就会【保存并退出】vim编辑器。

如果你不放心可以进入文件管理中查看

细心的你会发现其实就是加了一个hadoop的路径

其实有了上面的配置信息以后【Spark】就可以把数据存储到【Hadoop分布式文件系统HDFS】中也可以从HDFS中读取数据。如果没有配置上面信息Spark就只能读写本地数据无法读写HDFS数据

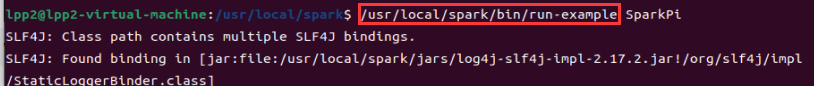

8直接使用它bin下面的这个命令来运行试试运行它自带的实例检查是否安装成功

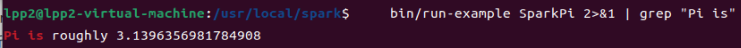

9使用管道过滤信息

bin/run-example SparkPi 2>&1 | grep "Pi is"

如果输出π即可

3、在集群上运行Spark应用程序

- 1.standalone模式

与MapReduce1.0框架类似Spark框架本身也自带了完整的资源调度管理服务可以独立部署到一个集群中而不需要依赖其他系统来为其提供资源管理调度服务。在架构的设计上Spark与MapReduce1.0完全一致都是由一个Master和若干个Slave构成并且以槽slot作为资源分配单位。不同的是Spark中的槽不再像MapReduce1.0那样分为Map 槽和Reduce槽而是只设计了统一的一种槽提供给各种任务来使用。 - 2.Spark on Mesos模式

Mesos是一种资源调度管理框架可以为运行在它上面的Spark提供服务。Spark on Mesos模式中Spark程序所需要的各种资源都由Mesos负责调度。由于Mesos和Spark存在一定的血缘关系因此Spark这个框架在进行设计开发的时候就充分考虑到了对Mesos的充分支持因此相对而言Spark运行在Mesos上要比运行在YARN上更加灵活、自然。目前Spark官方推荐采用这种模式所以许多公司在实际应用中也采用该模式。

- Spark on YARN模式

Spark可运行于YARN之上与Hadoop进行统一部署即“Spark on YARN”其架构如图9-13所示资源管理和调度依赖YARN分布式存储则依赖HDFS。

集群环境搭建http://dblab.xmu.edu.cn/blog/1187-2/

这里采用3台机器节点作为实例来演示如何搭建Spark集群

- 其中1台机器节点作为

Master节点 - 另外两台机器节点作为

Slave节点即作为Worker节点主机名分别为Slave01和Slave02。

待更新…

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |