Hadoop配置手册2: 测试Hdfs和WordCount测试

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

Hadoop配置手册2

Date: September 26, 2022

第3章 测试Hdfs和WordCount测试

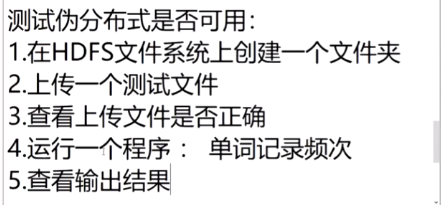

任务浏览

3.1 Hdfs测试

- 在HDFS文件系统上创建一个文件夹

cd /usr

mkdir data/

vim 1.txt

- 并上传一个测试文件

hadoop fs -put /usr/data/1.txt /test

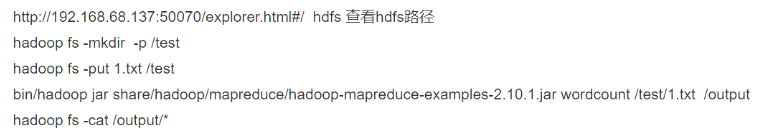

- 查看上传文件是否正确

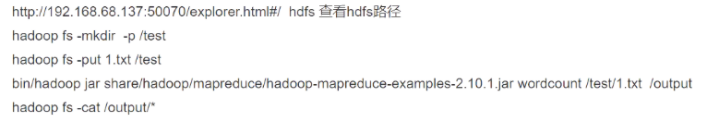

http://192.168.8.130:50070/explorer.html#/

常用hadoop指令

在hadoop指定目录内创建新目录

hadoop fs –mkdir /user/t

//eg hadoop fs -mkdir - p /user/centos/hadoop

从linux上传文件到hdfs中

hadoop fs -put 1.txt /user

//将当前linux目录下的1.txt文件上传到/user(hdfs服务器上的user目录下)

将本地文件/文件夹存储至hadoop

hadoop fs –put [本地目录] [hadoop目录]

//eg hadoop fs –put /home/t/file.txt /user/t

将hadoop上某个文件down至本地已有目录下

hadoop fs -get [文件目录] [本地目录]

//eg hadoop fs –get /user/t/ok.txt /home/t

查看文件内容: text/-cat

hadoop fs -text /hello

hadoop fs -cat /hello

3.2 WordCount测试

- 找到hadoop自带的jar包

//我的jar路径

/usr/hadoop/hadoop-2.10.1/share/hadoop/mapreduce

//我的jar包版本

hadoop-mapreduce-examples-2.10.1.jar

注意由于版本可能不同建议自己在这个位置附近找找

- 在linux本地创建文件

vim /tmp/wordcount.txt

注自己随便写点东西进去最好重复几行

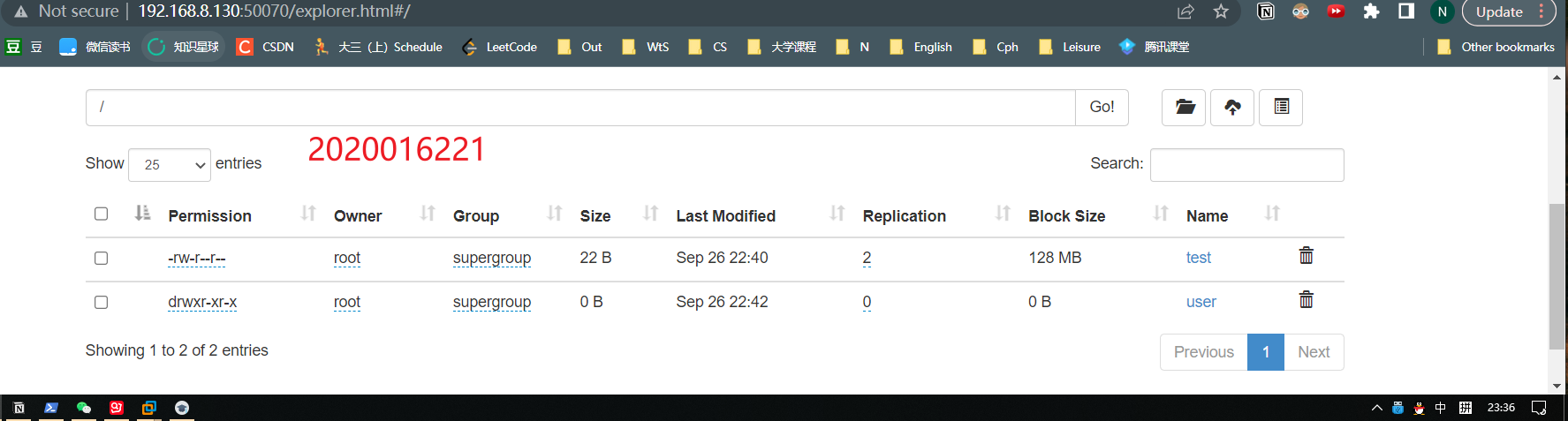

- 在云端创建文件夹

hadoop fs –mkdir /test_wordcount

- 将本地文件上传到云端

hadoop fs -put /tmp/wordcount.txt /test_wordcount

- Hadoop中检查文件

http://192.168.8.130:50070/explorer.html#/

- 运行程序单词记录频次

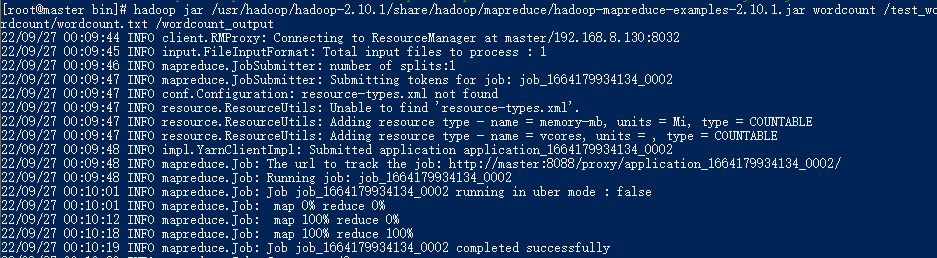

hadoop jar /usr/hadoop/hadoop-2.10.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.10.1.jar wordcount /test_wordcount/wordcount.txt /wordcount_output

hadoop jar /usr/hadoop/hadoop-2.10.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.10.1.jar wordcount /test_wordcount/wordcount.txt /wordcount_output

注1这里一定要先cd到 ……bin/hadoop 下才能执行 hadoop

注2命令最后的/wordcount_output是系统生成的用于输出的文件夹这个文件夹提前新建会报错

运行结果

看到最后的successfully 就代表成功了

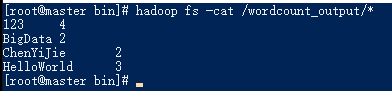

- 查看输出结果

hadoop fs -cat /wordcount_output/*

心得命令的参数的功能自己一定要清楚不能一味照抄