GraspNet-1Billion

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

目录

.1 intro

contribution:

-

一个具有统一评价体系的大规模抓取姿态检测数据集

-

评估系统通过解析计算直接报告抓取是否成功它可以评估任何一种抓取姿势而不需要穷尽地标注ground truth

-

一种end2end的抓取姿态预测网络在该网络中以一种确定的方式来学习逼近方向和操作参数。

-

为了提高抓取的稳健性设计了一种新型抓取亲和场。

Intro:

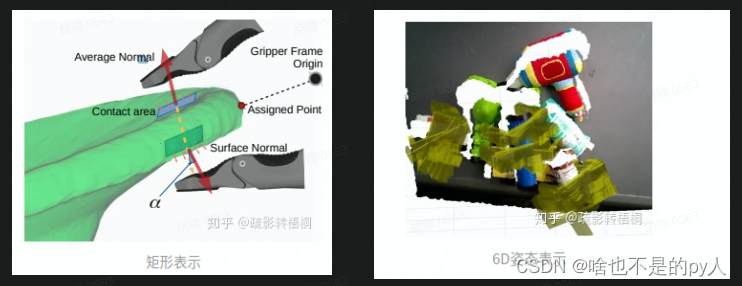

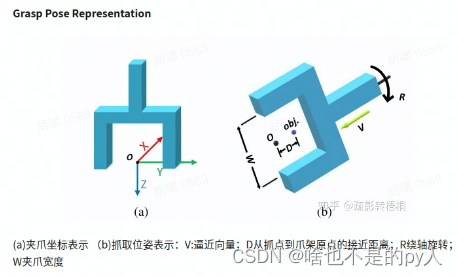

难点1.抓取姿态有不同的表示包括矩形和6D姿态表示

难点2:很难获得大规模高质量的训练数据

创新:

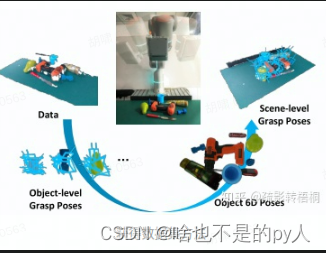

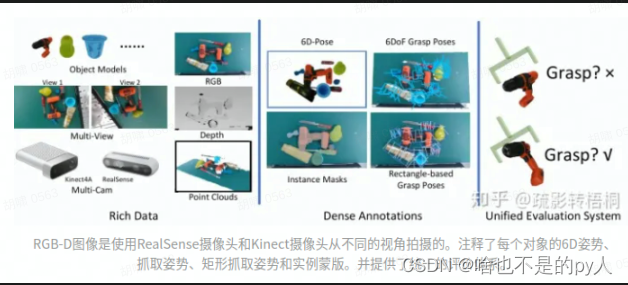

1.构建数据集的方法。我们用真实世界的传感器收集数据并通过解析计算为每个单独的物体标注抓取姿势。手动注释对象6D姿势以将抓取姿势从对象坐标投影到场景坐标。这种方法极大地减少了标注抓握姿势的劳动。我们的数据集既有密集的注释又与真实世界视觉上一致。

2.为了更好地进行几何推理和上下文编码我们提出了一种端到端的3D抓取姿态检测网络。该网络不是直接预测抓取姿态矩阵而是寻求一种更稳健的学习方式在统一目标下显式学习逼近方向和操作参数(如面内旋转、抓取宽度)。它采用了一种新的抓取姿势表示而不是直接回归

3.此外为了提高抓取姿态的抗扰性提出了抓取亲和场的新表示法使网络具有较强的抗扰动能力。

下图为论文解决思路

related work:

1.基于抓取预测算法的深度学习

->根据图像输入检测可抓取的矩形基于平面

->基于6D位姿估计并将预先定义的抓握姿势投射到场景中需要预先知道抓取物体的形状

->在部分观察到的点云上抓取候选对象并使用3D CNN输出每个候选对象的分类分数。

2.抓取数据集

-> 矩形标注人工标注的抓取数据集cornell

-> 用机器人执行抓取获得抓取数据集google那篇工作

-> 仿真标注dex-net 但是问题是传感器差距会导致问题

-> 像素级标注affordanceGraspSeg

3.基于点云的深度学习

-> 原始点云学习PointNet

-> 分割分类Point系列

->抓取位置预测S4G

.2 Dataset

该数据集包含88个具有高质量3D网格模型的日常对象。这些图像是从190个杂乱的场景中收集的每个场景都贡献了两个不同摄像头拍摄的512张RGB-D图像总共带来了97,280张图像。

对于每幅图像通过力闭合的解析计算来密集地标注6-DOF抓取姿势[29]。每个场景的抓握姿势从300万到900万不等我们的数据集总共包含超过11亿个抓握姿势。

此外还提供了精确的对象6D姿势标注、基于矩形的抓取姿势、对象蒙版和包围盒。每一帧还与一个相机姿势相关联因此可以很容易地融合多个视点云。

2.1 data collection:

场景设置:对于每个场景我们从整个对象集中随机挑选大约10个对象并以杂乱的方式放置它们。

标定方式:相机在机械臂上。

2.2 data annotation

6D Pose Annotation:

每个场景的第一帧注释6D姿势。6d姿态将传播到剩余帧。

grasp pose annotation:

力闭合

2.3 evaluation

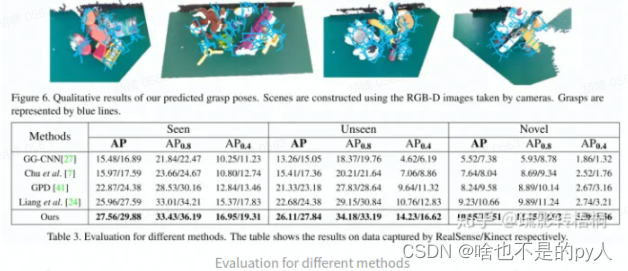

数据集拆分:共190个场景100个用于训练集90个用于测试集。测试集中30个用于见过的物体30个用于没见过但相似的物体30个用于新物体。

对于每个预测的抓取姿势ˆPI我们通过检查抓取器内部的点云将其与目标对象相关联。然后类似于抓取标注的生成过程在给定不同的µ的情况下我们可以通过力闭合度量得到每个抓取姿势的二进制标签。

.3 backbone

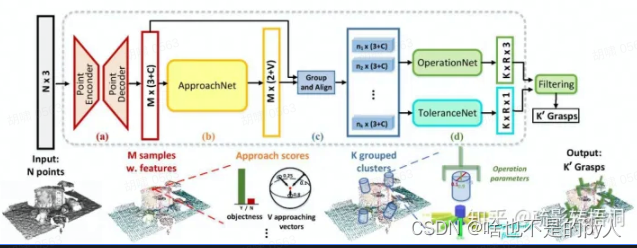

end2end网络架构;

点云输入然后编码提取M个点然后解码输出这M个点

采用PointNet++N×3大小的原始点云作为输入输出一组新的具有C个特征的点3+c

输入M个3+c通过Approachnet输出M个(2+v),2表示是否可掌握的二进制类V表示预定义接近向量的数量。

组合M个3+c和M个2+v--生成圆柱形的抓取区域每个区域里ni个抓取点ni*3+c

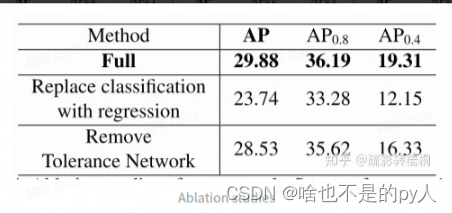

把ni*3+c[圆柱区域]输入Operation Network和Tolerance Network

Operation Network 把ni*3+c分成K个区域 每个区域有R个抓取位姿 输出 K个R*3

Tolerance Network 筛选出好的抓取位姿 输出 每个K最好的R

最后结合 Operation Network和Tolerance Network的输出进行过滤输出K个Grasps

Loss Function 候选点可以被抓取条件:

1.点是否在物体上

2.在半径5mm的范围内至少具有一个可抓取ground-truth

3.1 Training and Inference

通过根据抓取分数将抓取姿势划分为10个类来优化抓取姿势

最后inference的时候输入点输出可抓取位姿

3.2 Experiment