机器学习基础之《回归与聚类算法(2)—欠拟合与过拟合》-CSDN博客

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

一、背景

1、上一篇说正规方程的时候实际情况中使用很少主要原因它不能解决过拟合。

2、训练集上表现的好测试集上表现不好—过拟合

二、欠拟合和过拟合

1、欠拟合

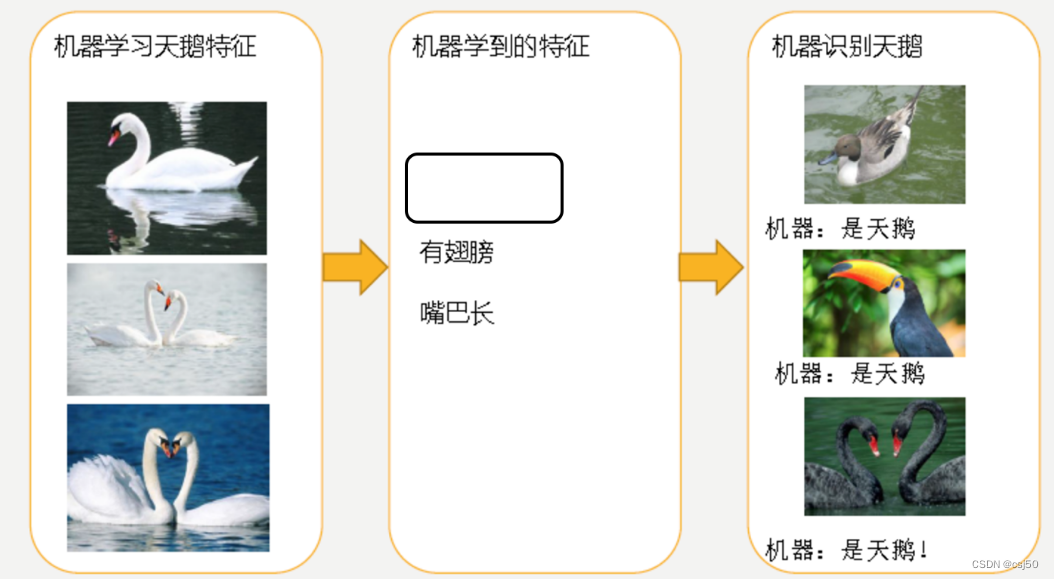

训练集有3个训练集告诉机器都是天鹅

机器学到了2个特征有翅膀、嘴巴长

缺点学习到的特征太少了

2、过拟合

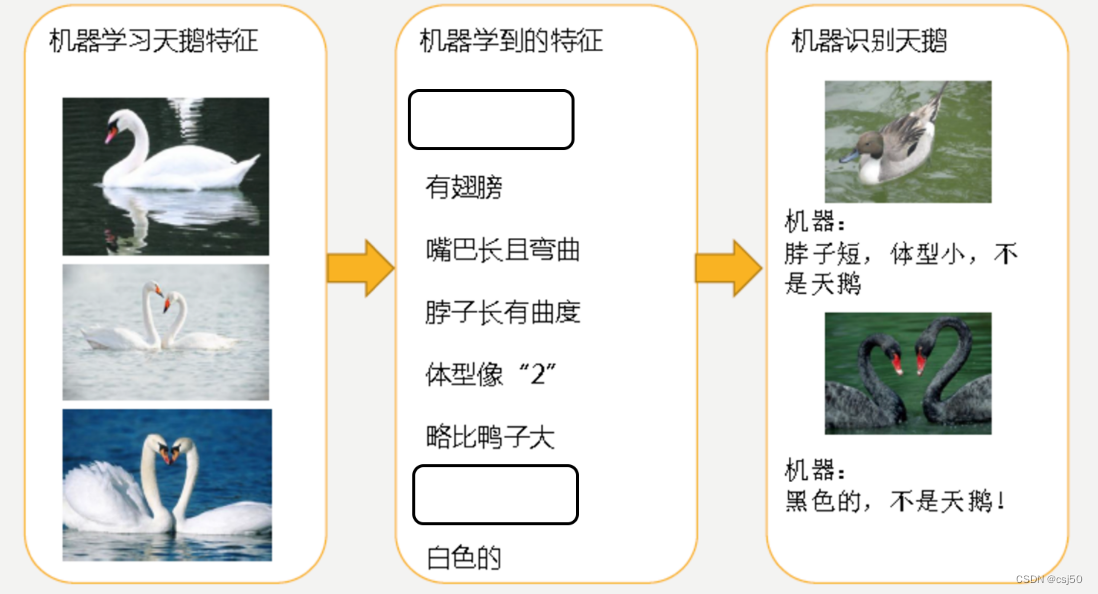

之前特征太少了那就多学点

缺点学习到的特征太多了

3、分析

第一种情况因为机器学习到的天鹅特征太少了导致区分标准太粗糙不能准确识别出天鹅。

第二种情况机器已经基本能区别天鹅和其他动物了。然后很不巧已有的天鹅图片全是白天鹅的于是机器经过学习后会认为天鹅的羽毛都是白的以后看到羽毛是黑的天鹅就会认为那不是天鹅。

三、定义

1、欠拟合

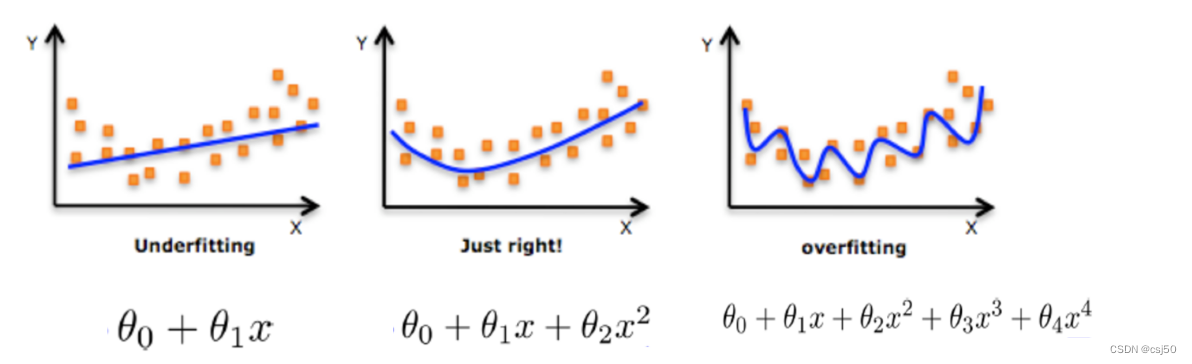

一个假设在训练数据上不能获得更好的拟合并且在测试数据集上也不能很好地拟合数据此时认为这个假设出现了欠拟合的现象。(模型过于简单)

2、过拟合

一个假设在训练数据上能够获得比其他假设更好的拟合 但是在测试数据集上却不能很好地拟合数据此时认为这个假设出现了过拟合的现象。(模型过于复杂)

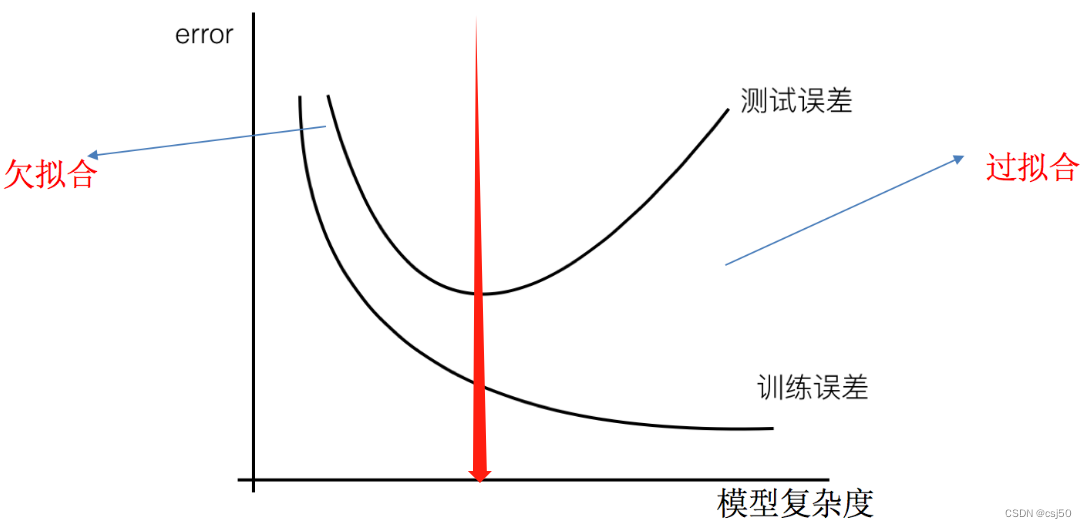

3、用图来表示这样一个过程

训练误差这一条线随着不断地进行训练损失值越来越少模型复杂度越来越多

测试误差这一条线一开始是误差随着模型复杂度越来越小但是到一定程度之后临界值随着模型复杂度进一步增加在测试集上误差会变大

在临界值左边的欠拟合训练集表现不好测试集表现也不好

在临界值右边的过拟合训练集表现好测试集表现不好

四、解决办法

1、欠拟合解决办法

原因学习到数据的特征过少

解决办法增加数据的特征数量

2、过拟合解决办法

原因原始特征过多存在一些嘈杂特征 模型过于复杂是因为模型尝试去兼顾各个测试数据点

解决办法正则化

3、在这里针对回归我们选择了正则化。但是对于其他机器学习算法如分类算法来说也会出现这样的问题除了一些算法本身作用之外决策树、神经网络我们更多的也是去自己做特征选择包括之前说的删除、合并一些特征

4、在学习的时候数据提供的特征有些影响模型复杂度或者这个特征的数据点异常较多所以算法在学习的时候尽量减少这个特征的影响甚至删除某个特征的影响这就是正则化

5、注意调整时候算法并不知道某个特征影响而是去调整参数得出优化的结果

五、正则化

1、L2正则化更常用

作用可以使得模型中模型参数W权重系数尽可能的接近于0削弱某些特征的影响

优点越小的参数说明模型越简单越简单的模型则越不容易产生过拟合现象

别名Ridge回归岭回归

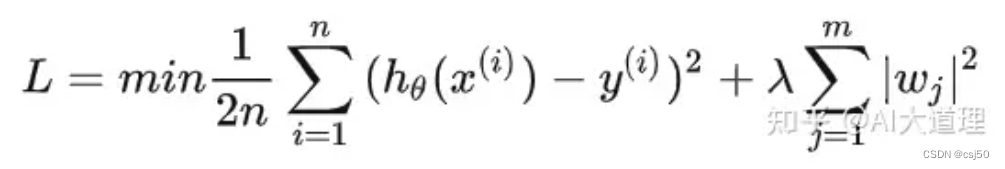

加入L2正则化后的损失函数

损失函数 + λ * 惩罚项

1用【预测值】-【真实值】然后求平方和然后除以2m

2惩罚项是权重值平方然后加在一起。第一个权重的平方加到最后一个权重的平方

3λ是惩罚的步长

4n为样本数m为特征数

2、L1正则化

作用可以使得其中一些W的值直接为0删除这个特征的影响

别名LASSO回归

加入L1正则化后的损失函数

损失函数 + λ * 惩罚项

1惩罚项是W的绝对值加在一起