走近Python爬虫(二):常见反爬虫机制的应对措施-CSDN博客

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |

文章目录

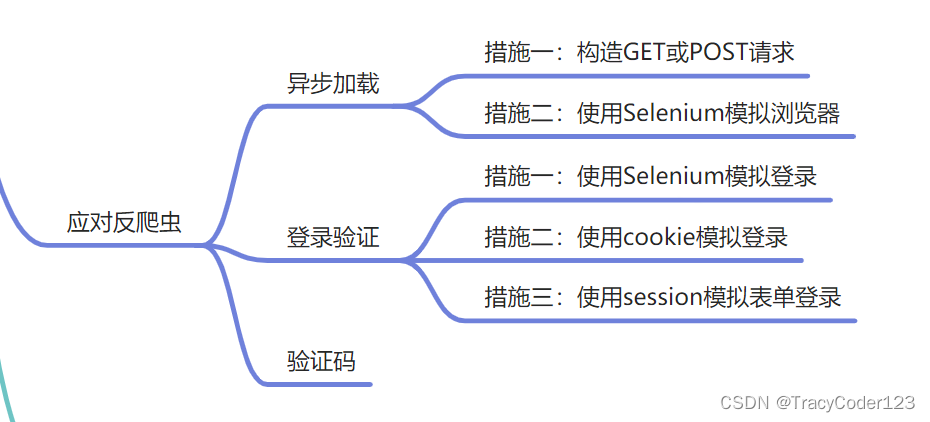

本文是Python爬虫系列博客的第二篇内容概览如下

一、应对—异步加载

1.一般措施

- AJAX技术介绍

AJAX是Asynchronous JavaScript And XML的首字母缩写意为异步JavaScript与XML。使用AJAX技术可以在不刷新网页的情况下更新网页数据。使用AJAX技术的网页一般会使用HTML编写网页的框架。在打开网页的时候首先加载的是这个框架。剩下的部分将会在框架加载完成以后再通过JavaScript从后台加载。

网页上面存在的某些文字在源代码中却不存在的情况绝大部分都是使用了异步加载技术。

- 应对思路

+++当我们发现某个接口获取数据的前提是向服务器发起GET或POST请求然后在response中获取网页数据。我们可以使用Python模拟浏览器使用浏览器的请求头和请求体发送GET或POST请求。

+++有一些网页显示在页面上的内容要经过多次异步请求才能得到。第1个AJAX请求返回的是第2个请求的参数第2个请求的返回内容又是第3个请求的参数只有得到了上一个请求里面的有用信息才能发起下一个请求。像这种情况解决思路也是通过构造一个又一个的请求来获取最终数据。不过在这个过程中需要有深厚的代码功底否则难以看懂经过了混淆的源代码。

+++包括基于异步加载的简单登录也可以通过这种方式来实现从而获得相应的通过口令。

2.Selenium

虽然在网页的源代码中无法看到被异步加载的内容但是在Chrome的开发者工具的“Elements”选项卡下却可以看到网页上的内容这就说明Chrome开发者工具“Elements”选项卡里面的HTML代码和网页源代码中的HTML代码是不一样的。在开发者工具中此时显示的内容是已经加载完成的内容。如果能够获得这个被加载的内容那么就能绕过手动构造的过程可以直接使用XPath来获得想要的内容。

这种情况下就需要使用Selenium操作浏览器来解析JavaScript再爬取被解析以后的代码。

- 安装

pip install selenium

下载ChromeDriver根据自己的系统选择合适的版本并安装。

- 代码

可以根据实际情况修改until条件。

from selenium import webdriver

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

driver = webdriver.Chrome('./chromedriver')

# 获取页面

try:

WebDriverWait(driver, 30).until(EC.presence_of_element_located((By.CLASS_NAME, "content")))

except Exception as _:

print(’网页加载太慢不想等了。')

# 查找资源

print(driver.page_source)

comment = driver.find_element_by_xpath('//div[@class="content"]')

print(comment.text)

comment = driver.find_elements_by_xpath('//p[starts-with(@id, "content_")]')

for each in comment:

print(each.text)

二、应对—登录验证

1.使用Selenium模拟登录

优点是简单有效缺点是它的速度太慢了不适合用于大规模的爬虫开发。

1初始化ChromeDriver。

2打开知乎登录页面。

3找到用户名的输入框输入用户名。

4找到密码输入框输入用户名。

5手动单击验证码。

6按下Enter键。

- 示例代码

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

driver = webdriver.Chrome('./chromedriver') #填写你的chromedriver的路径

driver.get("https://www.zhihu.com/#signin")

elem = driver.find_element_by_name("account") #寻找账号输入框

elem.clear()

elem.send_keys("xxx@gmail.com") #输入账号

password = driver.find_element_by_name('password') #寻找密码输入框

password.clear()

password.send_keys("12345678") #输入密码

input(’请在网页上点击倒立的文字完成以后回到这里按任意键继续。')

elem.send_keys(Keys.RETURN) #模拟键盘回车键

time.sleep(10)#这里可以直接sleep也可以等待某个条件出现

print(driver.page_source)

driver.quit()

2.使用Cookies登录

为了不让用户每次访问网站都进行登录操作浏览器会在用户第一次登录成功以后放一段加密的信息在Cookies中。下次用户访问网站先检查Cookies有没有这个加密信息如果有并且合法那么就跳过登录操作直接进入登录后的页面。通过已经登录的Cookies可以让爬虫绕过登录过程直接进入登录以后的页面。

使用Cookie来登录网页不仅可以绕过登录步骤还可以绕过网站的验证码。

3.使用Session模拟表单登录

因为某些网站的登录过程中涉及到了页面跳转但是我们却无法感知到中间的某些跳转因此仅仅是模拟一步GET/POST请求无法实现模拟登陆可能需要分多步进行。

在这种情况下使用python requests的Session模块来模拟这个登录。

- 代码示例

import requests

login_url='xxx'

login_success='xxxx'

data={

'username':'111',

'password':'1111'

}

session=requests.Session()

# step1

session.post(login_url,data=data).text

# step2

after_login=session.get(login_success).text

print(after_login)

三、应对—验证码

对于一次登录就可以长时间使用的情况只需要识别一次验证码即可。这种情况下与其花时间开发一个自动识别验证码的程序不如直接肉眼识别。

- 借助浏览器肉眼识别

对于需要输入验证码才能进行登录的网站可以手动在浏览器登录网站并通过Chrome获取Cookies然后使用Cookies来访问网站。这样就可以实现人工输入一次验证码然后很长时间不再登录。有一些网站的验证码是通过单击或者拖动滑块来验证的。对于这种网站目前最简单的办法就是使用Cookies来登录其他方式都不好用。

- 借助代码Session肉眼识别

1爬虫访问登录页面。

2分析网页源代码获取验证码地址。

3下载验证码到本地。

4打开验证码人眼读取内容。

5构造POST的数据填入验证码。

6POST提交。

| 阿里云国内75折 回扣 微信号:monov8 |

| 阿里云国际,腾讯云国际,低至75折。AWS 93折 免费开户实名账号 代冲值 优惠多多 微信号:monov8 飞机:@monov6 |